Une créature du nom d’Intelligence Artificielle (IA) a émergé dans nos laboratoires informatiques. On entend à son sujet tant d’histoires qu’il est presque impossible de s’en faire un avis bien tranché. Est-elle dangereuse, hostile à l’homme ? Difficile à dire. Face à cet inquiétant monstre numérique, la France vient de publier le « rapport Villani » pour « définir une stratégie nationale et européenne » et « donner un sens à l’intelligence artificielle ». Cette réponse sera-t-elle suffisante ?

Pour le savoir, il nous faudra nous-mêmes plonger dans cet océan de la robotique, de l’informatique et du Web, et étudier la bête de plus près. Nous verrons alors si elle est à craindre ou si elle peut nous être utile. Et en fonction, agir en citoyen avisé.

Le réveil du Kraken

Ce ne fut pas chose facile mais nous l’avons capturé et l’avons grand ouvert, cet algorithme dernier cri. Ce qui le distingue ? Son système digestif. Oui, notre intelligence artificielle moderne est un extraordinaire « digéreur » de données, bien plus efficace que ses prédécesseurs. Plus efficace car il peut désormais apprendre, chose que, jusqu’à présent, nous n’avons jamais réussi à faire faire à nos robots et autres programmes informatiques classiques (et que l’homme a, lui, toujours su faire naturellement).

Or, pour apprendre, notre machine doit pouvoir s’entraîner, beaucoup s’entraîner. Disposer pour cela d’une gigantesque base de données et d’une puissance de calcul monumentale pour pouvoir la traiter correctement. La technologie qu’elle nécessite est telle qu’on a longtemps cru la chose impossible. Jusqu’à ce qu’au sein des célèbres laboratoires Bell, un chercheur français, Yann LeCun, élabore avec son équipe à partir des années 90 les premiers programmes d’apprentissage machine dits d’apprentissage profond, à l’aide de la technologie des réseaux de neurones convolutifs.

Il faut ensuite attendre la seconde décennie du XXIe siècle, avec la montée en puissance des calculateurs informatiques, ainsi que l’émergence du Big Data (l’énorme base de données que constitue l’Internet aujourd’hui), pour que notre nouveau « Kraken » algorithmique se réveille enfin.

Un cerveau dans l’estomac ?

Notre monstre informatique, donc, ingurgite autant qu’il peut des données provenant d’images, de fichiers sons et autres supports numériques. Comment les digère-t-il ? A l’aide de ces fameux neurones convolutifs.

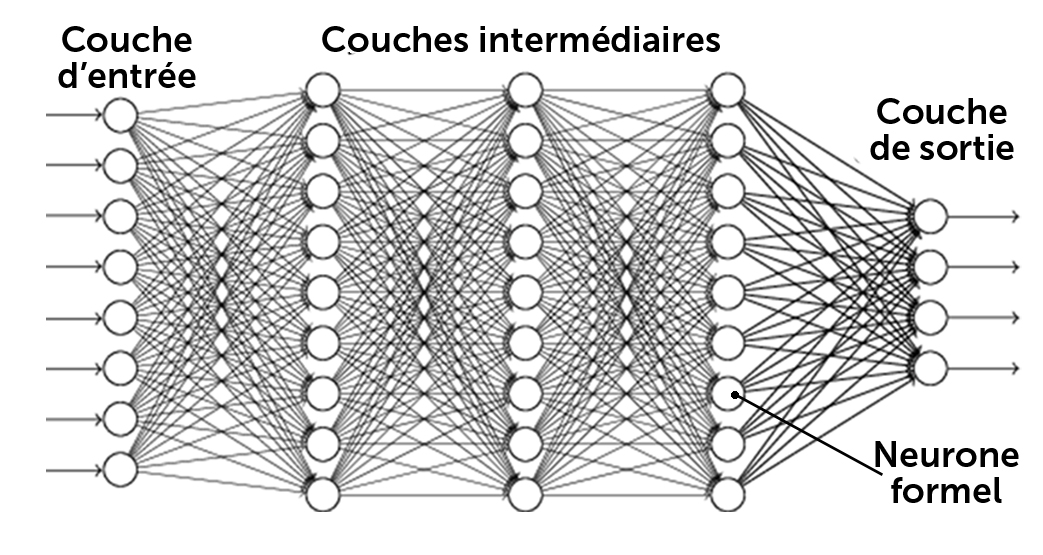

Des algorithmes simples qui captent les signaux binaires en entrée pour en restituer d’autres en sorties. Dans son estomac, un très grand nombre de ces neurones (plusieurs millions, voire milliards) s’organisent en couches successives communiquant les unes avec les autres.

Un capharnaüm combinatoire très complexe qui nécessite une puissance de calcul hors norme pour en venir à bout. Une fois les données rentrées, notre machine mouline donc un tas de chiffres à travers son réseau jusqu’à produire en sortie un résultat.

Donnez-lui une image de votre adorable petit matou et elle vous répondra quelque chose du type : « Il y a 33 % de chances qu’il y ait un chat sur cette image ».

Etant donné qu’elle s’avère un peu ignorante et incapable de donner une réponse statistiquement satisfaisante au départ, on lui indique son erreur. Là, on lui applique un algorithme à l’aide d’une fonction mathématique bien précise qui affine ses réglages internes et lui permet de corriger petit à petit cette erreur pour qu’elle se trompe moins par la suite. C’est ainsi que la machine finit par « apprendre ». On lui fait subir ici ce qu’on appelle un apprentissage supervisé, puis on la teste avec de nouvelles données qui lui sont inconnues pour voir si ses réponses en sortie correspondent à ce qu’on attend d’elle statistiquement parlant.

Intelligence artificielle…

Notre grosse bestiole, une fois pleinement entraînée, semble alors faire preuve d’une sorte d’« intelligence » : elle détecte désormais les objets, les caractères ou les personnes sur une photo quelconque (reconnaissance faciale, lecture de plaques d’immatriculation, etc.), retranscrit des scènes sur des vidéos, reconnaît les caractères d’une écriture manuscrite personnelle.

Plus fascinant encore, notre nouvelle intelligence artificielle peut « prévoir » ou « prédire » un événement. En extrayant certaines caractéristiques générales à partir des données qu’elle traite, elle peut (si on le lui demande) établir un « modèle prédictif » très performant et extrapoler statistiquement de nouveaux résultats. Tant qu’elle peut avoir des données à disposition pour s’entraîner, elle se perfectionne par induction successive, dans la limite, évidemment, de ce pourquoi elle a été initialement programmée. Sa puissance réside avant tout dans sa rapidité ; sa fiabilité, dans la fiabilité des données qu’on lui donne à digérer.

Et avec nos smartphones, nos ordinateurs, nos montres, nos caméras de surveillance, nos satellites et nos voitures hyper-connectés, c’est une sorte de « buffet à volonté » de données qui s’offre à elle chaque jour ! Du coup, elle s’est invitée dans notre quotidien sans crier gare.

Elle est devenue un compagnon indispensable dans nos déplacements, sur route ou dans les transports en commun, et nous offre même, déjà et sous certaines conditions, la possibilité de voyager dans des véhicules autonomes. Elle peut optimiser en temps réel nos processus de production industrielle en réduisant au maximum les stocks et le gaspillage de matières premières, améliorer notre consommation énergétique, optimiser l’utilisation d’eau et de produits chimiques dans notre agriculture. Ses capacités prédictives peuvent aussi servir à prévoir la météo ou le risque de catastrophes naturelles.

Elle sait également assister les médecins dans leur diagnostic. Le programme Watson d’IBM s’y affaire déjà, prescrivant des traitements pour des tumeurs cancéreuses après avoir analysé leur séquençage ADN. Rien ne semble pouvoir arrêter notre chère IA ! C’est une touche-à-tout sans laquelle nous ne pourrions vivre aujourd’hui.

Mais alors, certains s’inquiètent : « Nous volera-t-elle nos emplois ? Ceux du tertiaire qui jusqu’ici avaient été préservés de la robotisation du travail ? » A en croire certains chercheurs, les emplois les plus menacés seront avant tout ceux qui ne nécessitent ni empathie ni réelle créativité. Resteront donc les plus intéressants et les plus stimulants humainement et émotionnellement. Et dans la mesure où de nouveaux métiers plus créatifs seront aussi créés par l’innovation technologique qui la caractérise, l’intelligence artificielle, comme la robotisation mécanique avant elle, pourra nous libérer des travaux les plus répétitifs et les plus abrutissants. Elle participerait ainsi à l’élévation matérielle et morale de la société, pour peu que personne ne soit laissé au bord du chemin de l’éducation et de la formation. Tout dépend des choix qui seront faits.

…préoccupations réelles

Mais à qui reviennent ces choix ? Là est la vraie question. Aujourd’hui, ils reviennent principalement aux géants du numérique. Ceux-là mêmes qui chaque jour aspirent en masse nos données et accaparent les technologies des NBICs (nanotechnologies, biotechnologies, informatique et sciences cognitives) pour modeler de nouvelles IA selon leur convenance.

Les GAFAM américains (Google, Apple, Facebook, Amazon, Microsoft), les BATX chinois (Baïdu, Alibaba, Tencent, Xiaomi), constituent aujourd’hui de véritables empires face auxquels nos propres pouvoirs nationaux peinent à s’imposer (sans même parler des institutions européennes). Leur mainmise sur nos données leur confère un énorme pouvoir et rien ne laisse présager qu’ils l’utiliseront pour le bien commun.

« Exagération ! » me diront certains. « Jeff Bezos, Mark Zuckerberg, Elon Musk, Bill Gates ne veulent que notre bien. Voyez d’ailleurs comment certains parmi eux nous mettent en garde contre les dangers de l’IA ! »

C’est vrai. Mais on sait ô combien il peut être avantageux pour un pyromane de s’afficher en pompier protecteur ! C’est ce qu’explique très rigoureusement Jean-Gabriel Ganascia, professeur à l’Université Pierre et Marie Curie et directeur de l’équipe ACASA (Agents cognitifs et apprentissage symbolique automatique) au laboratoire d’informatique de Paris VI, dans son dernier ouvrage Le mythe de la Singularité.

Pour lui, il ne fait aucun doute que la stratégie de communication anxiogène des GAFAM sur l’IA vise avant tout à nous focaliser sur la technologie pour nous faire oublier ceux qui la contrôlent. Car le monde enchanté des start-up du numérique n’est joli que de façade. A l’intérieur, un darwinisme économique et social des plus féroces s’est solidement installé. Google paie merveilleusement bien ses petits génies en informatique, certes, mais tournez-vous vers les préparateurs de commandes et livreurs d’Amazon et vous discernerez plus exactement la stratégie commerciale prédatrice de ces géants de la mondialisation financière.

Vous rêvez de gagner vos galons à la Station F de Xavier Niels, ou dans une autre de ces pépinières numériques qui poussent aujourd’hui plus vite que des champignons ? Il faudra jouer des coudes et, peut-être, sacrifier votre créativité aux désirs des plus grands groupes avides d’idées rentables. Plus concrètement, 90% des start-up françaises ont dû cesser leurs activités cinq ans après leur création. Et quant à Facebook, le scandale « Cambridge Analytica » parle de lui-même.

Non, les multimilliardaires du net ne sont pas des humanistes, soyons clairs là-dessus. Ils sont là pour servir leurs intérêts avant toute chose, suivant les prémices du système financier qui les a fait naître. A tel point qu’ils menacent aujourd’hui de faire disparaître notre souveraineté et celle de nos Etats en s’appropriant une à une leurs principales prérogatives régaliennes.

A commencer par :

- la cybersécurité, la cyberdéfense (contrats attribuant à Microsoft la gestion des données du ministère de la Défense) et la sécurité intérieure (écoutes de la NSA, contrat du renseignement français avec la société californienne Palantir, spécialisée dans l’extraction et le traitement en masse de données, et dont l’actuel PDG, Pieter Thiel, n’est autre que le conseiller numérique de Donald Trump) ;

- la monnaie (avec les Bit-Coins et autres crypto-monnaies spéculatives) ; l’éducation (accord conclu en novembre 2015 entre Najat Vallaud-Belkacem et Microsoft pour le développement du plan numérique de l’école française) ;

- la justice (prédiction des récidives criminelles aux Etats-Unis à l’aide du programme Compass) ; et enfin

- la santé (projet Baseline de Google pour la collecte massive de données médicales).

Le véritable enjeu se situe là, dans notre capacité à répondre à l’emprise de ces GAFAM. C’est un enjeu politique majeur dont doivent se saisir nos élus et tous nos concitoyens. Craindre la technologie et la condamner, c’est s’égarer : ce qu’il faut, c’est s’assurer qu’elle se trouve entre de bonnes mains et qu’elle soit mise au service de tous.

Pour cela il est avant tout nécessaire de nous prémunir de ce pessimisme culturel induit par ceux qui veulent nous décourager, ceux qui professent un futur apocalyptique dénué de toute humanité. C’est sur ce terrain-là, sur la manière de penser l’homme qu’il nous faut combattre. Sans quoi, nous succomberons au chant des sirènes et resterons impuissants à bâtir un avenir plus juste.

Le chant des sirènes

Car elles chantent ces sirènes !

- Elon Musk (co-fondateur de PayPal avec Peter Thiel, et actuel directeur de SpaceX),

- Ray Kurzweil (futurologue et ingénieur IA chez Google),

- Laurent Alexandre (fondateur du site Doctissimo), ou encore

- Yuval Noah Harari (célèbre auteur d’Homo Deus, une brève histoire de l’avenir) – pour ne citer qu’eux.

Tous, à leur manière, professent l’avènement d’une nouvelle ère transhumaniste, une ère régie par la nouvelle religion des données, le Dataïsme, et dans laquelle l’individu, réduit à un conglomérat de données numériques, d’algorithmes biochimiques et électrochimiques, disparaît au sein du grand Cloud universel interconnecté.

Dans ce monde, une minorité de cyborgs transhumains privilégiés, transformés en demi-dieux par les NBICs, contrôleront à leur guise la masse d’inutiles inactifs. Et ce, jusqu’au moment fatal de la Singularité : ce moment charnière où la machine, douée de conscience, aura définitivement dépassé l’homme en intelligence et suivra son propre destin.

Comment nos prophètes envisagent-ils de nous sortir de cette sombre perspective ? Cela dépend. Yuval Noah Hariri, en bon Candide voltairien du XXIe siècle, préconise un plongeon dans la spiritualité, un retour aux choses simples, au bonheur de cultiver son jardin intérieur par la méditation (certainement sous la protection bienveillante des « élites Alpha » transhumaines ou du Dieu des datas ?).

Ray Kurzweil, lui, espère vivre jusqu’au moment de la Singularité, qu’il prévoit pour 2045, et ce en ingurgitant chaque jour des dizaines de pilules et autres vitamines. Il compte pouvoir ainsi, au moment fatidique, transférer sa conscience dans un ordinateur et devenir immortel ! Laurent Alexandre, en eugéniste intellectuel décomplexé, préconise quant à lui dans son dernier ouvrage La guerre des intelligences, un neuro-renforcement des faibles QI pour combler leur défaillance vis-à-vis de l’élite intellectuelle génétiquement favorisée.

En somme, une bonne hygiène pasteurienne des cerveaux pour effacer les inégalités intellectuelles naturelles et pour se préserver des désagréments sociaux dus à l’émergence de l’IA ! Une éventualité à laquelle se prépare certainement Elon Musk en fondant la firme Neuralink. Cette dernière est en effet spécialisée dans le développement futur de composants bio-électroniques et de capteurs invasifs censés donner au cerveau humain les moyens de se brancher et de se fondre dans les méandres informatiques de l’intelligence artificielle de demain.

Prophéties auto-réalisatrices ? Fables chimériques ? Oui et non. Les dangers d’un dérapage vers une société inégalitaire existent bel et bien. Mais c’est la conception de l’homme sous-tendant toutes ces théories qui pose réellement problème. Penser que l’homme ne se résume qu’à un simple algorithme de connexions électrochimiques et neurologiques, et concevoir ainsi la possibilité qu’il soit dépassé par une autre forme d’intelligence artificielle supérieure, c’est oublier la véritable intelligence humaine, l’imagination créatrice, la capacité de découvrir des principes physiques nouveaux. C’est oublier qui crée la machine et pourquoi.

Ce qui découvre, c’est l’esprit, pas la machine

Car on imagine difficilement un robot avoir une conscience et agir selon sa propre volonté. Les émotions, les sentiments, la notion d’amour, de justice, de compassion, de beauté même, tout cela ne se programme pas.

Nous n’avons pas le code numérique pour modéliser ces concepts fondamentaux. Une IA peut assimiler toutes les plus belles œuvres de Bach et vous restituer une pièce musicale certes mélodiquement très proche des originales, mais elle n’aura jamais le principe unificateur de la composition, la véritable beauté, ni même la conscience qu’elle compose de la musique ! Elle peut être une très bonne imitatrice de notre comportement mais elle n’en reste pas moins un automate livré au bon vouloir de son programmeur, fonctionnant toujours par induction et déduction statistiques de données numériques.

Même l’AlphaGo Zéro, qui bat tous les champions au jeu de go, n’a pas conscience de jouer au go et ne fait que « traiter » un nombre quasi illimité de données en employant toutes les combinaisons possibles pour définir une stratégie dans une règle du jeu formelle et extérieure à lui-même.

L’homme ne fonctionne pas ainsi. Sa capacité de découvrir ne dépend pas du nombre d’expériences qu’il accumule mais de son imagination créatrice basée sur la raison, sur l’élaboration d’idées et de principes physiques universels. Bien souvent même, les expériences ne lui sont utiles que pour révéler les limites de ses théories et le pousser à penser au-delà. L’homme émet des hypothèses supérieures. La science qu’il acquiert n’est jamais issue de l’induction à proprement parler, elle vient de sa pensée, de sa capacité à créer.

Le cas de Kepler

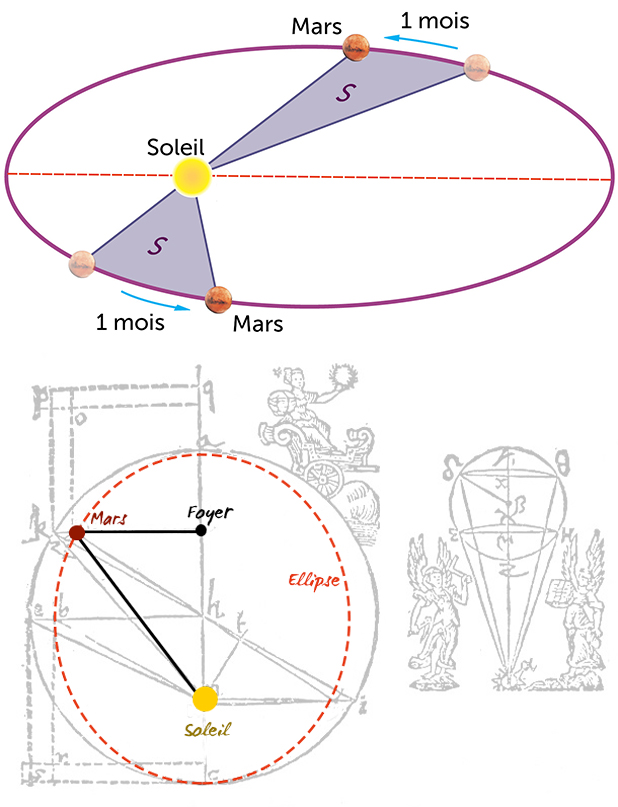

Pour nous en convaincre, comparons le cas de l’astronome danois Tycho Brahe et du grand découvreur Jean Kepler. A la fin du XVIe siècle, Brahe était l’observateur du ciel le plus passionné et doué de sa génération. Il a su rassembler et même réaliser les mesures astronomiques les plus précises et les plus complètes qu’il n’avait jamais été donné à l’humanité d’avoir. Il possédait en quelque sorte, en matière d’astronomie, le Big Data de l’époque (les fameuses Tables rudolphines). Pourtant, il n’a pas découvert les secrets du système solaire. Celui qui a réussi à en percer les mystères, c’est Kepler.

Il faut bien comprendre qu’avant Kepler, les données astronomiques ne servaient qu’à élaborer des modèles pour décrire formellement le mouvement des astres sur la voûte céleste. Pour cela, les astronomes faisaient appel à des outils mathématiques pour ajuster leurs modèles : des cercles et des épicycles pour décrire les orbites, des équants pour définir des points hypothétiques de l’espace autour desquels les astres devaient tourner uniformément.

Qu’il s’agisse du modèle de Ptolémée (géocentrique : Terre au centre), de Copernic (héliocentrique : Soleil au centre) ou de Tycho Brahe (synthèse géocentrique et héliocentrique), tous étaient mathématiquement équivalents du point de vue des simples observations combinant des données. Aucun de ces modèles ne visait à expliquer les causes physiques qui animaient les planètes, à mettre en évidence les « raisons » de leur mouvement.

C’est ici que Kepler entre en jeu. Ce qu’il fait, dès le départ, c’est chercher non seulement à comprendre « comment » fonctionne le système solaire mais bien plus encore « pourquoi » il s’organise ainsi et pas autrement. Cette approche le mène à concevoir un premier modèle d’une originalité sans pareil situant le Soleil au centre et corrélant l’organisation des six orbites planétaires connues à l’époque avec les sphères inscrites et circonscrites des cinq solides platoniciens ordonnés harmoniquement

Cette première hypothèse basée sur une vision harmonique et unifiée du monde, bien qu’incomplète, le conforte dans le choix du modèle héliocentrique comme seul pouvant rendre compte d’une réalité physique.

Voulant aller plus loin, il se concentre alors sur la planète Mars et utilise les données de Tycho Brahe et les outils mathématiques de ses prédécesseurs pour construire un modèle d’orbite martienne bien plus précis que tout ce qui a été fait auparavant. Puis, considérant l’orbite sous un autre angle, avec d’autres mesures, il montre en quoi ce modèle mathématique, apparemment si parfait, comporte une erreur qui le fera s’écrouler tout entier sur lui-même. Fini le cercle, fini l’équant ! Les données ne permettent plus d’établir la réalité du monde. Kepler est face à l’inconnu. Son esprit doit chercher une idée nouvelle.

Il garde constamment cette conviction qu’il faut une raison nécessaire au fonctionnement du système solaire. Il considère la nécessité d’un principe moteur unique qu’il situe dans le Soleil.

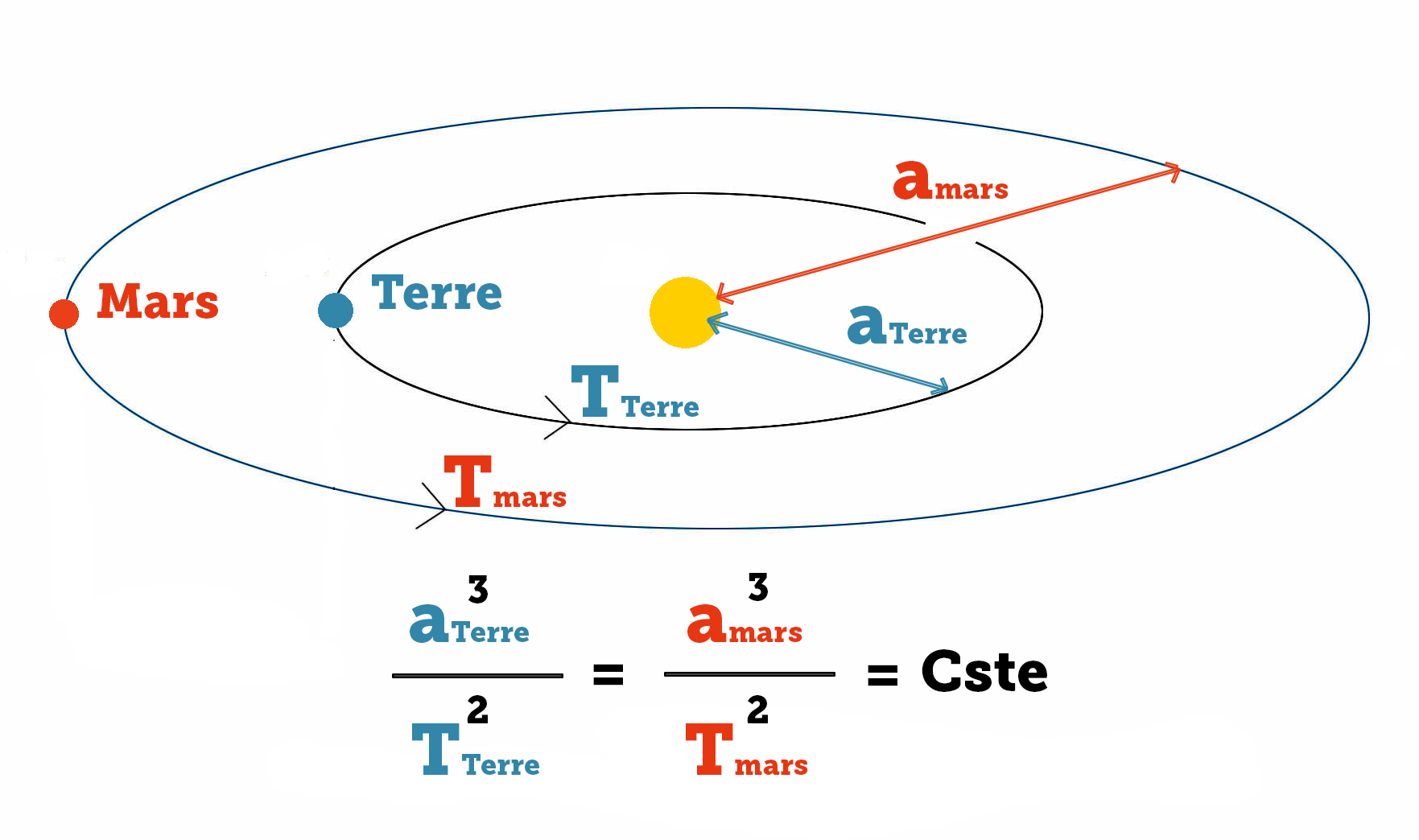

Il découvre alors la fameuse « loi des aires », stipulant que les planètes, vues du Soleil, doivent balayer des aires égales en des temps égaux, et détermine à partir de cette première loi la forme elliptique des orbites planétaires.

Enfin, suivant toujours son intuition créatrice selon laquelle le système solaire doit nécessairement former un tout cohérent et harmonieux, il révèle l’étonnante similitude entre l’agencement des planètes dans leur mouvement et les rapports harmoniques de la gamme musicale, et découvre ainsi sa troisième loi sur les périodes sidérales planétaires

Ainsi pour Kepler, la détermination des trajectoires elliptiques et des périodes sidérales n’a pas précédé sa compréhension physique du fonctionnement du système solaire mais fut la conséquence intellectuelle de sa recherche de la causalité physique.

Entendant cela, certains experts scientifiques nous rétorqueront peut-être que, sans en arriver aux considérations métaphysiques de Kepler, il serait tout à fait envisageable de programmer une intelligence artificielle capable d’induire ces mêmes lois à partir des données de vitesse et de position des planètes. Après tout, les équations du fameux double pendule mécanique, dit « chaotique », qu’on pensait jusqu’ici impossible à déterminer à partir des mesures expérimentales, viennent d’être récemment redécouvertes à partir d’un puissant algorithme. Donc, en effet, rien n’empêche d’imaginer une IA capable de restituer le mouvement des planètes à partir des simples mesures astronomiques.

Mais affirmer cela c’est ignorer la différence qu’il y a entre décrire un phénomène et chercher à en comprendre la cause véritable. C’est aussi oublier le fait que, pour que ces IA puissent révéler les lois en question, il faut les programmer avec des formules spécifiques qui, souvent, découlent elles-mêmes de la découverte originale. Sans la découverte, donc, rien n’indique qu’on puisse programmer correctement notre machine.

En résumé, un algorithme peut tout à fait nous être utile pour faire apparaître des corrélations que nous n’aurions pas réussi à déceler dans les mesures. Mais il ne formulera jamais d’hypothèse supérieure pour en trouver les causes.

L’exemple d’Einstein

Prenons un autre exemple tout aussi parlant et souvent cité par le chercheur et philosophe des sciences français Etienne Klein : celui de la théorie de la relativité générale. A l’époque d’Albert Einstein, aucune donnée expérimentale ne permet de supposer qu’il existe a priori une possible unification entre les lois de l’électromagnétisme régies par le principe de relativité restreinte et celle de la gravitation. Cette conviction qu’il existe une loi universelle supérieure, Einstein la tient de sa propre intuition créatrice. Celle-ci le pousse à imaginer l’expérience d’un corps en chute libre et à envisager, par cette expérience mentale, l’équivalence entre la force inertielle d’accélération et la force gravitationnelle. La relativité générale ne naît pas ainsi des données de l’expérience mais d’une hypothèse supérieure issue de l’esprit du découvreur.

Plus frappant encore, la théorie prévoit l’existence de nouveaux phénomènes qui n’auraient certainement jamais été mesurés sans la découverte du principe lui-même (les ondes gravitationnelles en sont l’exemple le plus frappant). Autrement dit, ce ne sont pas les données qui induisent au principe mais le principe découvert qui pousse à chercher de nouvelles données.

« Les machines, un jour, pourront résoudre tous les problèmes, mais jamais aucune d’entre elles ne pourra en poser un ! » Ces quelques mots d’Einstein résument assez bien notre propos. Ils nous confortent dans cette idée que seule l’intelligence humaine est capable de formuler des concepts qui, bien que non conformes aux données empiriques et non directement observables, sont pourtant concordants avec les lois qui régissent notre Univers. Bref, l’intelligence humaine est tout sauf purement logique et inductive, tout sauf artificielle. Elle est créative.

Si nous oublions cela, ce qui arrangerait certainement les grands prophètes de l’apocalypse numérique, nous risquons en effet de devenir ce que par nature nous ne sommes pas : des robots déshumanisés, incapables de créer.

Mener le combat

Nous voilà remontés à la surface. L’horizon semble par endroit plus ensoleillé. Nous réfléchissons alors à comment mener le combat pour retrouver notre liberté menacée. Comment faire en sorte que nos dirigeants politiques comprennent l’enjeu ? Qu’ils défendent notre souveraineté, nos droits fondamentaux et l’intérêt général ? Pourquoi ne pas créer des algorithmes plus perfectionnés qui nécessiteront moins de données et nous rendront ainsi moins dépendants des GAFAM ? L’idée est bonne, mettons-y les moyens !

Aussi, engageons les hackeurs les plus doués afin qu’ils mettent leurs compétences au service du bien public. Proposons-leur cet engagement et voyons comment nos nations peuvent résister, préserver l’intérêt des peuples en se réappropriant la technologie, les données, et en établissant les lois à même de réduire l’emprise et la prédation de ces titans du numérique.

Dans son « rapport Villani », le gouvernement français s’engage à défendre une « politique de la donnée avec un objectif de souveraineté ». Voyons ce qu’il en est et poussons en effet dans ce sens. Mais la question reste les moyens mis en œuvre et la stratégie. Emmanuel Macron déclare vouloir investir 1,5 Md€ sur l’ensemble de son quinquennat pour stopper la « fuite des cerveaux » et miser sur les secteurs du transport, de la santé et de l’environnement pour rattraper le retard significatif de la France et de l’Europe face aux USA et à la Chine.

Il est malheureusement clair que cela ne sera pas suffisant pour irriguer les réseaux de recherche où s’expriment les initiatives créatrices. Surtout si, au final, il compte sur la générosité des acteurs privés pour compléter ces investissements. Une approche qui pourrait bien comporter certains risques dans le contexte actuel de mondialisation financière.

En principe, toutes les mesures proposées dans ce rapport paraissent bonnes, qu’il s’agisse du triplement du nombre de formations dans le secteur de l’IA dans les trois ans à venir, du doublement des salaires en début de carrière pour les jeunes diplômés, de la création d’Instituts interdisciplinaires de l’IA, de l’orientation de la commande publique vers plus d’innovation, de la création d’un guichet unique d’information dans le secteur du numérique, de même que la réflexion sur l’éthique que pose l’application de certaines technologies liées à l’IA.

Cependant, la grande absente, c’est la politique industrielle ambitieuse à mettre en place pour concevoir et produire physiquement les infrastructures techniques qui piloteront les algorithmes de nos meilleurs chercheurs, ainsi que leur financement. Le coût de ces machines nécessite en effet des investissements tels que seuls les grands groupes daignent les débourser pour leur utilisation « personnelle » et lucrative. La France et l’Europe désirent disposer d’un super calculateur pour en faire bénéficier les chercheurs et les entreprises, soit, mais il faudra alors s’en donner véritablement les moyens et agir en conséquence. Cela implique une politique d’investissements publics à grande échelle et sur le long terme, que la logique court-termiste dictée par les marchés financiers internationaux et les mêmes grands groupes ne permet pas.

Là se situe donc la véritable nature du combat : bâtir un système qui puisse libérer les nations de l’occupation financière destructrice pour que chacun puisse bénéficier des connaissances issues de la recherche et les technologies de pointe qui leur sont associées. C’est aussi résister à « l’occupation » des esprits qui consolide l’emprise de cette finance sur nos institutions et notre population, et ce, en se donnant les moyens d’une éducation mutuelle et exigeante capable d’éveiller au maximum les capacités créatrices de chacun, avec passion et amour de la vérité.

Pour que, forts de nos découvertes, nous puissions bâtir un avenir plus sûr pour notre espèce et savourer ensemble la joie d’être des citoyens engagés et pleinement souverains. Riant à pleins poumons du pessimisme, du fatalisme, contre le respect qui n’est pas dû.

« Pour ce que rire est le propre de l’homme »... pas de la machine.

COMMENTAIRES

COMMENTAIRES